最近各大科技巨头都在人工智能聊天机器人上发力,谷歌也不例外。它最新推出的Bard聊天机器人可以迅速生成任何东西——从关于莎翁文学的论文,到说唱歌词。但是以Bard为代表的这些聊天机器人还有一个严重的问题尚未解决。那就是它们有时会胡编乱造。

比如说,在CBS电视台上周日的《60分钟》节目上,Bard在谈到通胀问题时,曾自信满满地宣称,彼得·特明的《通胀战争:一部现代史》一书“讲述了美国的通胀史”,这本书还探讨了美国的通胀政策。问题是这本书根本就不存在。

问题是,Bard撒的这个谎具有很强的迷惑性。彼得·特明是麻省理工学院的一位知名经济学家,他研究的领域就是通货膨胀,而且写过十几本经济学方面的书,只不过没有任何一本叫这个名字。Bard在回答通胀问题时,不光“幻想”出了这本书,甚至还“幻想”出了一系列其他经济学书籍的名称和摘要。

Bard是谷歌推出的一款对标ChatGPT的聊天机器人,它是今年三月份才刚刚发布的,但它已经不只一次在公开场合闹笑话了。此前它曾在一次公开演示中声称,詹姆斯韦伯太空望远镜曾在2015年首次捕捉到一颗系外行星的照片,但是实际上,Bard所说的这颗行星是位于智利的“甚大望远镜”于2014年发现的。

像Bard和ChatGPT这样的聊天机器人都使用了大型语言模型(又称LLMs)来对数十亿个数据点进行分析,来预测语义中的下一个单词。这种方法又叫所谓的“生成式人工智能”。它有时会给产生一种言之凿凿的错觉,让人觉得它给出的答案是可信的,但事实并非如此。那么AI机器人的这种“一本正经地胡说八道”是否是一种普遍现象呢?

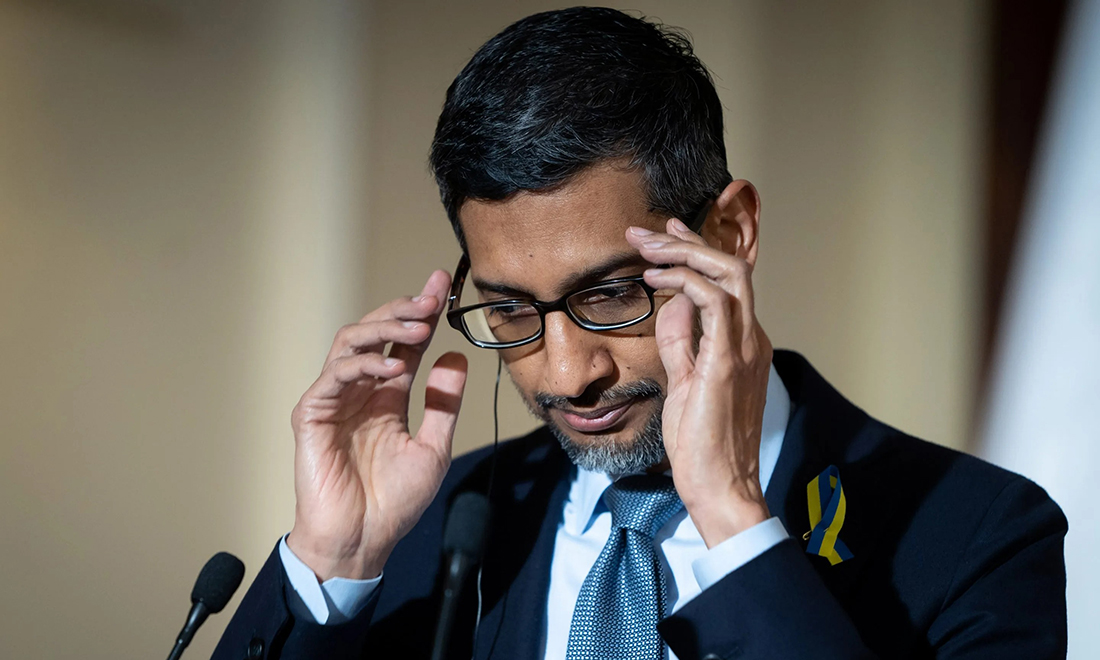

对此,谷歌CEO桑达尔·皮查伊上周日在接受《60分钟》采访时承认,这个问题是“意料之中”的。“这个领域目前还没有人能解决‘错觉’的问题。所有型号的生成式AI都存在这个问题。”

当被到这个问题未来是否会得到解决时,皮查伊表示:“在这个问题上有很多争论。”但他认为,他的团队最终会在这方面“取得进展”。

一些人工智能专家指出,由于人工智能系统的复杂性,要取得这种进展,可能是一件很困难的事。皮查伊表示,就连谷歌的工程师都“无法完全理解”人工智能技术有时为何会有那样的反应。

他表示:“我们这个领域的人把这方面的问题称为‘黑箱’。你也不知道它为什么会这样说,或者为什么会出错。”

皮查伊说,谷歌工程师们对AI聊天机器人的工作模式“已经有了一些概念”,他们对生成式AI的理解水平正在提高。“不过目前的技术水平就是这样。”不过对于一些批评人士来说,皮查伊这个解释显然不能让他们满意。不少批评人士警告说,复杂的人工智能系统很可能会引发意想不到的后果。

比如,微软创始人比尔·盖茨今年3月表示,人工智能技术的发展很可能会加剧全球的贫富差距。他在一篇博客文章中写道:“市场力量不可能自然而然地产生自动帮助穷人的AI产品和服务,更有可能发生的是相反的情况。”

最近几个月,伊隆·马斯克也反复在公开场合提到人工智能可能造成的风险。他表示,这项技术对经济的冲击将不亚于“小行星撞击地球”。上个月,马斯克甚至联名1100多位科技企业CEO、技术专家和AI研究人员,呼吁全球暂停开发人工智能工具6个月——当然很多人不知道的是,他同时正忙着创办自己的人工智能公司。

斯坦福大学人本AI研究中心曾对人工智能行业的从业者进行过一项年度调查,调查结果显示,很多AI从业者认为,人工智能技术的发展,使得“深度造假”变得越来越容易,这很可能会加剧虚假信息的泛滥,甚至有可能危害环境。该研究中心上周表示,AI带来的威胁甚至有可能达到“核级别的灾难”。

上周日,谷歌CEO皮查伊也在参加节目时透露,即便是在谷歌内部,也有一些研究人员担心,人工智能一旦应用不当,“可能会产生非常有害的影响”。他还表示:“我们尚未找到所有问题的答案,而且这项技术的发展是很快的。如果你问我,这个问题有没有可能让我睡不着觉,答案是当然肯定的。”

皮查伊还表示,为了确保人工智能造福所有人,AI系统的开发工作“不仅应该包括工程师,还应该包括社会科学家、伦理学家、哲学家等等”。

“我认为,这些问题是社会在发展过程中需要解决的问题,而不应该由一个公司来决定。”他说。(财富中文网)

译者:朴成奎

最近各大科技巨头都在人工智能聊天机器人上发力,谷歌也不例外。它最新推出的Bard聊天机器人可以迅速生成任何东西——从关于莎翁文学的论文,到说唱歌词。但是以Bard为代表的这些聊天机器人还有一个严重的问题尚未解决。那就是它们有时会胡编乱造。

比如说,在CBS电视台上周日的《60分钟》节目上,Bard在谈到通胀问题时,曾自信满满地宣称,彼得·特明的《通胀战争:一部现代史》一书“讲述了美国的通胀史”,这本书还探讨了美国的通胀政策。问题是这本书根本就不存在。

问题是,Bard撒的这个谎具有很强的迷惑性。彼得·特明是麻省理工学院的一位知名经济学家,他研究的领域就是通货膨胀,而且写过十几本经济学方面的书,只不过没有任何一本叫这个名字。Bard在回答通胀问题时,不光“幻想”出了这本书,甚至还“幻想”出了一系列其他经济学书籍的名称和摘要。

Bard是谷歌推出的一款对标ChatGPT的聊天机器人,它是今年三月份才刚刚发布的,但它已经不只一次在公开场合闹笑话了。此前它曾在一次公开演示中声称,詹姆斯韦伯太空望远镜曾在2015年首次捕捉到一颗系外行星的照片,但是实际上,Bard所说的这颗行星是位于智利的“甚大望远镜”于2014年发现的。

像Bard和ChatGPT这样的聊天机器人都使用了大型语言模型(又称LLMs)来对数十亿个数据点进行分析,来预测语义中的下一个单词。这种方法又叫所谓的“生成式人工智能”。它有时会给产生一种言之凿凿的错觉,让人觉得它给出的答案是可信的,但事实并非如此。那么AI机器人的这种“一本正经地胡说八道”是否是一种普遍现象呢?

对此,谷歌CEO桑达尔·皮查伊上周日在接受《60分钟》采访时承认,这个问题是“意料之中”的。“这个领域目前还没有人能解决‘错觉’的问题。所有型号的生成式AI都存在这个问题。”

当被到这个问题未来是否会得到解决时,皮查伊表示:“在这个问题上有很多争论。”但他认为,他的团队最终会在这方面“取得进展”。

一些人工智能专家指出,由于人工智能系统的复杂性,要取得这种进展,可能是一件很困难的事。皮查伊表示,就连谷歌的工程师都“无法完全理解”人工智能技术有时为何会有那样的反应。

他表示:“我们这个领域的人把这方面的问题称为‘黑箱’。你也不知道它为什么会这样说,或者为什么会出错。”

皮查伊说,谷歌工程师们对AI聊天机器人的工作模式“已经有了一些概念”,他们对生成式AI的理解水平正在提高。“不过目前的技术水平就是这样。”不过对于一些批评人士来说,皮查伊这个解释显然不能让他们满意。不少批评人士警告说,复杂的人工智能系统很可能会引发意想不到的后果。

比如,微软创始人比尔·盖茨今年3月表示,人工智能技术的发展很可能会加剧全球的贫富差距。他在一篇博客文章中写道:“市场力量不可能自然而然地产生自动帮助穷人的AI产品和服务,更有可能发生的是相反的情况。”

最近几个月,伊隆·马斯克也反复在公开场合提到人工智能可能造成的风险。他表示,这项技术对经济的冲击将不亚于“小行星撞击地球”。上个月,马斯克甚至联名1100多位科技企业CEO、技术专家和AI研究人员,呼吁全球暂停开发人工智能工具6个月——当然很多人不知道的是,他同时正忙着创办自己的人工智能公司。

斯坦福大学人本AI研究中心曾对人工智能行业的从业者进行过一项年度调查,调查结果显示,很多AI从业者认为,人工智能技术的发展,使得“深度造假”变得越来越容易,这很可能会加剧虚假信息的泛滥,甚至有可能危害环境。该研究中心上周表示,AI带来的威胁甚至有可能达到“核级别的灾难”。

上周日,谷歌CEO皮查伊也在参加节目时透露,即便是在谷歌内部,也有一些研究人员担心,人工智能一旦应用不当,“可能会产生非常有害的影响”。他还表示:“我们尚未找到所有问题的答案,而且这项技术的发展是很快的。如果你问我,这个问题有没有可能让我睡不着觉,答案是当然肯定的。”

皮查伊还表示,为了确保人工智能造福所有人,AI系统的开发工作“不仅应该包括工程师,还应该包括社会科学家、伦理学家、哲学家等等”。

“我认为,这些问题是社会在发展过程中需要解决的问题,而不应该由一个公司来决定。”他说。(财富中文网)

译者:朴成奎

Google’s new chatbot, Bard, is part of a revolutionary wave of artificial intelligence (A.I.) being developed that can rapidly generate anything from an essay on William Shakespeare to rap lyrics in the style of DMX. But Bard and all of its chatbot peers still have at least one serious problem—they sometimes make stuff up.

The latest evidence of this unwelcome tendency was displayed during CBS’ 60 Minutes on Sunday. The Inflation Wars: A Modern History by Peter Temin “provides a history of inflation in the United States” and discusses the policies that have been used to control it, Bard confidently declared during the report. The problem is the book doesn’t exist.

It’s an interesting lie by Bard—because it could be true. Temin is an accomplished MIT economist who studies inflation and has written over a dozen books on economics, he just never wrote one called The Inflation Wars: A Modern History. Bard “hallucinated” that, as well as names and summaries for a whole list of other economics books in response to a question about inflation.

It’s not the first public error the chatbot has made. When Bard was released in March to counter OpenAI’s rival ChatGPT, it claimed in a public demonstration that the James Webb Space Telescope was the first to capture an image of an exoplanet in 2005, but the aptly named Very Large Telescope had actually accomplished the task a year earlier in Chile.

Chatbots like Bard and ChatGPT use large language models, or LLMs, that leverage billions of data points to predict the next word in a string of text. This method of so-called generative A.I. tends to produce hallucinations in which the models generate text that appears plausible, yet isn’t factual. But with all the work being done on LLMs, are these types of hallucinations still common?

“Yes,” Google CEO Sundar Pichai admitted in his 60 Minutes interview Sunday, saying they’re “expected.” “No one in the field has yet solved the hallucination problems. All models do have this as an issue.”

When asked if the hallucination problem will be solved in the future, Pichai noted “it’s a matter of intense debate,” but said he thinks his team will eventually “make progress.”

That progress may be difficult to come by, as some A.I. experts have noted, due to the complex nature of A.I. systems. Pichai explained that there are still parts of A.I. technology that his engineers “don’t fully understand.”

“There is an aspect of this which we call—all of us in the field—call it a ‘black box,’” he said. “And you can’t quite tell why it said this, or why it got it wrong.”

Pichai said his engineers “have some ideas” about how their chatbot works, and their ability to understand the model is improving. “But that’s where the state of the art is,” he noted. That answer may not be good enough for some critics who warn about potential unintended consequences of complex A.I. systems, however.

Microsoft cofounder Bill Gates, for example, argued in March that the development of A.I. tech could exacerbate wealth inequality globally. “Market forces won’t naturally produce AI products and services that help the poorest,” the billionaire wrote in a blog post. “The opposite is more likely.”

And Elon Musk has been sounding the alarm about the dangers of A.I. for months now, arguing the technology will hit the economy “like an asteroid.” The Tesla and Twitter CEO was part of a group of more than 1,100 CEOs, technologists, and A.I. researchers who called for a six-month pause on developing A.I. tools last month—even though he was busy creating his own rival A.I. startup behind the scenes.

A.I. systems could also exacerbate the flood of misinformation through the creation of deep fakes—hoax images of events or people created by A.I.—and even harm the environment, according to researchers surveyed in an annual report on the technology by Stanford University’s Institute for Human-Centered A.I., who warned the threat amounts to a potential “nuclear-level catastrophe” last week.

On Sunday, Google’s Pichai revealed he shares some of the researchers’ concerns, arguing A.I. “can be very harmful” if deployed improperly. “We don’t have all the answers there yet—and the technology is moving fast. So does that keep me up at night? Absolutely,” he said.

Pichai added that the development of A.I. systems should include “not just engineers, but social scientists, ethicists, philosophers, and so on” to ensure the outcome benefits everyone.

“I think these are all things society needs to figure out as we move along. It’s not for a company to decide,” he said.